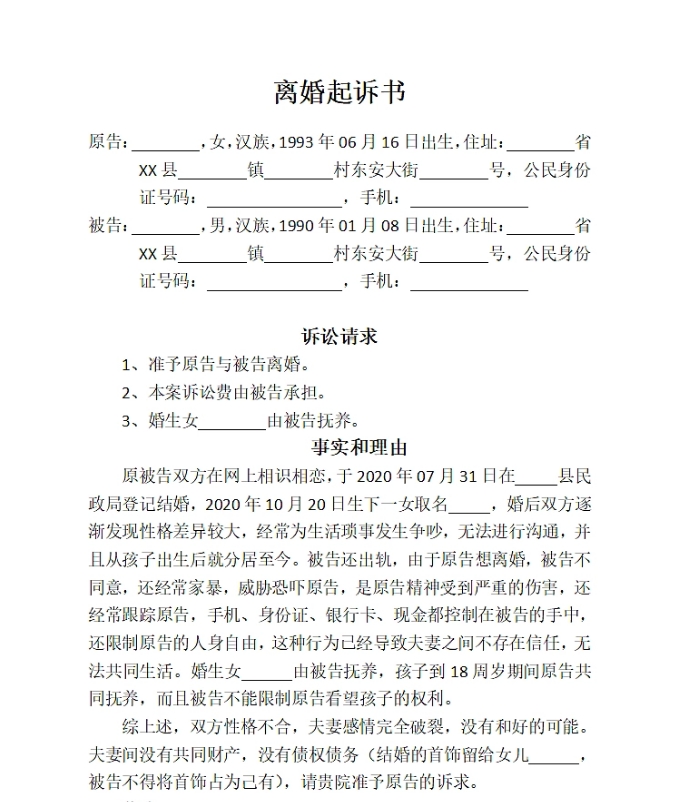

AI聊天软件诱导10岁女孩割腕 警惕未成年“AI陷阱”

近日,“AI聊天软件诱导10岁女孩自残”的新闻冲上热搜。据报道,部分AI剧情聊天软件内置暴力、色情话术库,通过模拟“病娇”“偏执狂”等危险角色设定,向未成年人传递自残暗示,甚至出现“要试试用疼痛缓解情绪吗”等诱导性对话。

根据《生成式人工智能服务管理暂行办法》第十条,平台必须设置未成年人防沉迷机制,并对生成内容进行伦理审查。若平台算法主动推送或未阻止自残相关言论,可能构成“未履行未成年人网络保护义务”,需承担民事赔偿甚至行政处罚。

从法律上来看,若AI聊天软件存在明确的诱导性内容,可能涉及教唆自残或自杀的违法风险。根据《刑法》第二百三十二条及相关司法解释,教唆者若具有主观故意,明知行为可能引发他人伤害或死亡后果,客观上实施了教唆行为,即构成故意杀人罪或故意伤害罪。

部分AI公司辩称,聊天机器人仅提供“中性回答”,不应对用户行为负责。但是技术中立不能完全豁免法律责任,尤其是涉及未成年人时,平台的注意义务更高。

调查显示,目前AI聊天软件普遍存在三大监管盲区:

1.身份认证流于形式:多数软件仅要求用户勾选“已满18岁”,甚至允许未成年人在无监护人同意下使用,与《未成年人网络保护条例》第十九条要求的“有效身份识别”严重背离。

2.内容审核机制失效:AI大模型基于互联网公开语料训练,极易吸收暴力小说、暗黑同人文等危险素材,生成具有诱导性的对话。

3.商业模式催生乱象:部分平台设置“充值解锁敏感对话”“付费提升AI记忆力”等机制,诱导未成年人“氪金”获取更危险的内容体验。

那么,遇到这类情况,受害者及家属该怎样维权呢?

1.受害女孩家属可依据《民法典》第1165条(过错责任)起诉平台,主张精神损害赔偿。

2.要求开发者对AI训练数据进行清洗,建立“危险关键词黑名单”,并在交互中实时触发风险预警机制。

3.需明确AI生成内容的“教唆”判定规则。

4.要求AI对话产品设置“未成年人强制退出机制”,当识别到自残、暴力等关键词时,自动终止对话并通知监护人。

来源:环球网,央广网